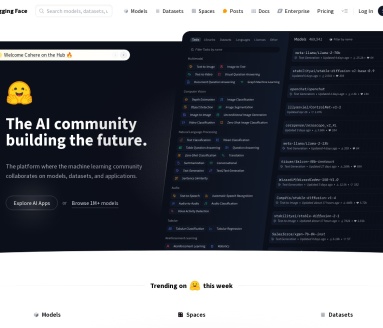

是什么

Hugging Face是一家总部位于纽约的法美公司,被称为“AI领域的GitHub”,是一个人工智能模型和数据共享、利用的开源平台。该平台目前有近90万个AI模型上传,通过开源和开放科学推动人工智能的发展和普及,简化AI和机器学习,为开发者提供易用的工具、预训练模型和可访问的库。

主要功能

1. 模型与数据集共享:拥有超350,000个模型、75,000个数据集,用户可上传、下载和分享各类AI模型与数据集。2. 预训练模型库:提供BERT、GPT、T5等大量自然语言处理任务的预训练模型,支持开发者快速调用。3. 演示应用:150,000个demo apps,方便用户直观体验模型功能。4. 开发工具:提供用户友好的工具,助力开发者进行情感分析、文本生成、语音转文本等任务。5. 硬件资源:用户不仅能免费使用CPU,还能付费使用包含GPU和加速器在内的7种优化的硬件。

应用场景

1. 自然语言处理:文本分类、情感分析、机器翻译、问答系统等。2. 文本生成:故事创作、摘要生成、对话系统等。3. 语音处理:语音识别、语音合成等。4. 计算机视觉:图像分类、目标检测等。5. 科研与教育:为研究人员和学生提供模型与数据,助力AI领域研究和学习。

适用人群

1. 机器学习开发者:可利用平台工具和模型快速开发应用。2. 数据科学家:用于数据处理、模型训练与优化。3. 研究人员:获取资源开展AI研究。4. 学生:学习AI知识和实践操作。

常见问题

1. **如何开始使用Hugging Face?** 首先,用户需创建一个Hugging Face账户,并安装Transformers库。可以通过pip命令安装:`pip install transformers`。接下来,可以选择预训练模型,并利用提供的API进行文本生成、问答、翻译等任务。2. **是否支持中文?** 是的,Hugging Face支持多种语言,包括中文。用户可以找到适合中文处理的模型,如BERT和RoBERTa等,并使用相应的tokenizer进行文本预处理。3. **如何 fine-tune 模型?** 用户可以使用Hugging Face提供的Trainer类,定义训练参数,包括批量大小、学习率等,加载自己的数据集,进行模型的微调。官方文档中有详细的示例代码。4. **模型的质量如何评估?** Hugging Face提供了多种评估指标,如准确率、F1-score等,用户可以在fine-tune后使用这些指标对模型进行评估。此外,可以通过在测试集上的表现来监测模型的泛化能力。5. **Hugging Face的模型如何分享?** 用户可以通过Hugging Face Model Hub将自己的模型分享给他人。只需遵循相关指引,将模型上传到平台即可,方便其他开发者使用。6. **如何解决模型加载速度慢的问题?** 如果模型加载速度慢,可以考虑使用模型压缩技术,如量化、剪枝等;此外,使用更高效的硬件或启用GPU加速也能有效提升加载速度。

使用技巧

Hugging Face是一个非常强大的自然语言处理工具,提供了多种模型和接口,使用户可以轻松实现各种 NLP 任务。以下是一些使用技巧:1. **充分利用模型库**:Hugging Face Hub上有众多预训练模型,用户可以根据自己的需求选择不同的模型,如BERT、GPT等,适合文本分类、生成、翻译等任务。2. **使用Transformers库**:通过Transformers库,可以方便地加载和使用预训练模型。使用 `from_pretrained` 方法可以快速获取指定模型及其权重,大大节省了训练时间和计算资源。3. **fine-tuning**:可以在自己的数据集上对预训练模型进行微调,利用 `Trainer` 类可以简化训练过程,快速达到较好的效果。4. **数据处理**:在数据处理方面,使用`datasets`库可以方便地加载和预处理数据,支持多种格式,如CSV、JSON等。5. **社区支持**:Hugging Face拥有活跃的社区,用户可以在论坛上提问、分享经验和寻找示例代码,帮助加快学习和解决问题的速度。通过以上技巧,用户可以更高效地利用Hugging Face进行自然语言处理任务,提升工作效率和模型性能。