是什么

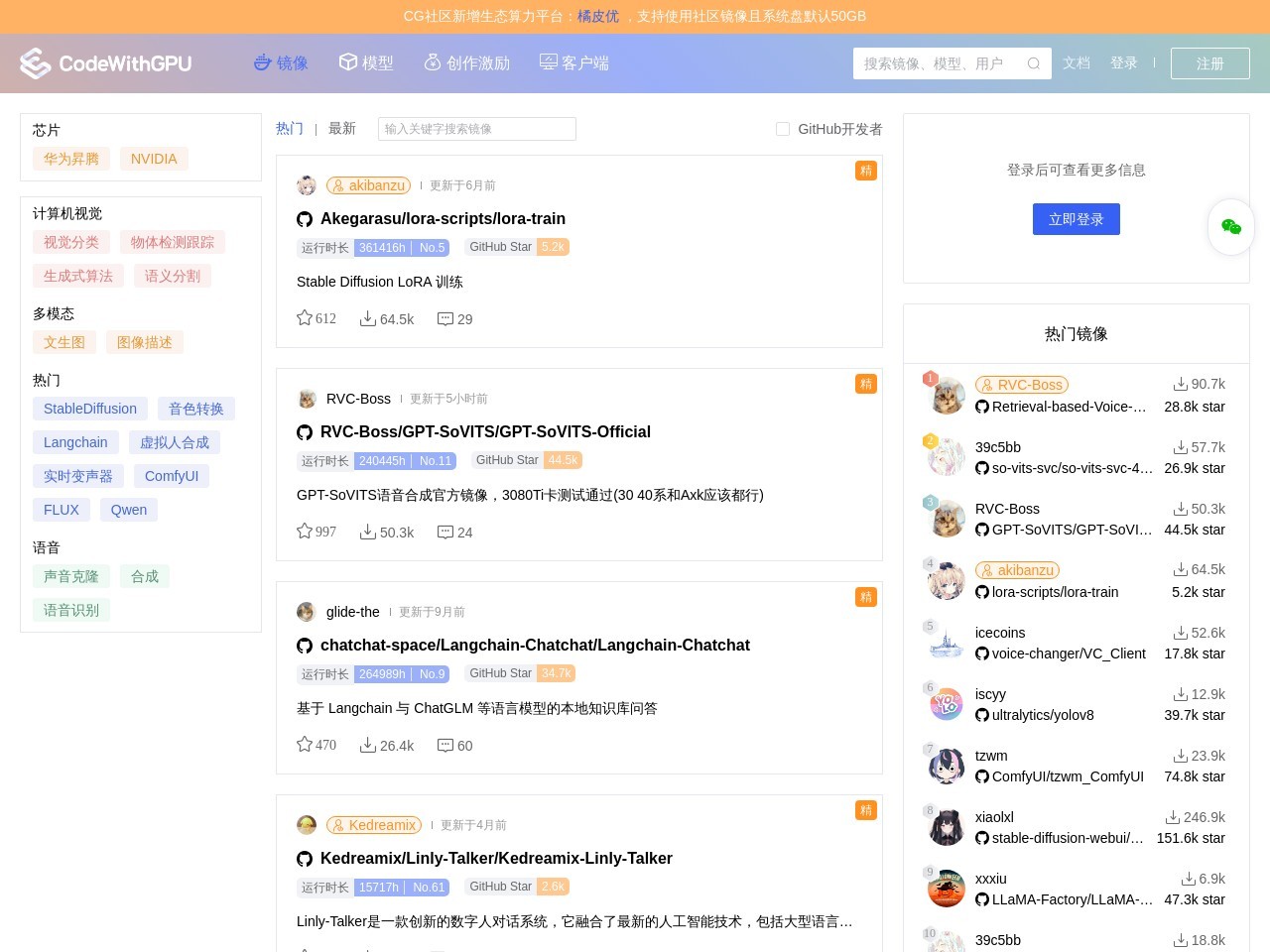

CodeWithGPU是一个综合性的AI相关平台,成立于2022年,总部位于中国南京,是一家A轮公司。它与Github集成,为可复现的AI算法提供社区支持,同时也是一个基于AutoDL平台的人工智能算法复现和悬赏网站,用户可以免费使用Nvidia GPU进行训练和推理。此外,它还提供Docker镜像和模型,是一个AI镜像、模型技术社区,致力于解决构建环境难、管理与分享模型难等问题。

主要功能

1. 数据加载:为AI应用提供数据加载解决方案。2. 模型服务:采用模块化的模型服务设计。3. 基准测试:针对多种加速器提供基准测试。4. 算法复现:支持复现Github上的深度学习项目。5. 模型管理:用户可发布、搜索和下载模型,还能查看模型的训练日志和文件。6. 镜像服务:提供Docker镜像,用户可使用镜像进行训练等操作。7. 悬赏功能:提供算法复现悬赏机制。

应用场景

1. 学术研究:研究人员可在该平台复现相关AI算法,进行实验和研究,利用免费的Nvidia GPU资源加速训练过程。2. 工业生产:企业开发者可以借助平台的模型服务和数据加载等功能,将AI算法应用到实际生产中,提高生产效率。3. 学习教育:初学者可以通过平台提供的丰富模型和镜像,学习和实践AI算法,了解深度学习项目的开发流程。4. 模型分享与交流:用户可以在平台上发布自己训练的模型,与其他开发者交流分享,促进AI技术的发展。

适用人群

1. AI研究人员:需要复现算法、进行实验对比的科研工作者。2. 企业开发者:负责将AI技术应用到产品中的开发人员。3. 深度学习爱好者:想要学习和实践AI算法的初学者。4. 模型开发者:希望分享自己训练成果的模型开发者。

常见问题

CodeWithGPU 是一款专为高性能计算和深度学习任务设计的工具,用户在使用过程中常常会遇到一些常见问题:1. **安装问题**:许多用户在安装 CodeWithGPU 时可能会遇到依赖库缺失或版本不兼容的问题。确保按照官方文档的要求安装所有依赖项,并定期检查更新。2. **性能优化**:用户在运行复杂模型时,可能会感到性能不足。建议优化模型结构,调整超参数,并充分利用GPU的并行计算能力。3. **数据格式问题**:在数据预处理阶段,用户有时会遭遇数据格式不一致的问题。务必检查输入数据的格式,并确保与模型的要求相符。4. **错误调试**:代码运行过程中可能会出现各种错误,用户需要仔细阅读错误信息,并根据提示进行调试,必要时可以参考社区论坛或官方文档进行解决。5. **资源管理**:在使用 CodeWithGPU 时,不当管理GPU资源可能会导致内存溢出等问题。建议定期监控GPU的使用情况,并合理安排任务调度。6. **环境配置**:有些用户在不同机器上使用 CodeWithGPU 时遇到环境配置不一致的情况,建议使用容器化技术(如Docker)来保持环境的一致性。 这些常见问题的解决方案可以帮助用户更高效地使用 CodeWithGPU,提升工作效率。

使用技巧

1. **高效利用GPU资源**:在使用CodeWithGPU时,确保选择适当的计算资源和配置,以最大化GPU的运算效率。了解您的任务规模,选择合适的GPU类型和数量,能够显著提高计算速度。2. **优化代码以适配GPU**:在编写代码时,注意使用支持GPU加速的库和框架,如TensorFlow、PyTorch等。这些框架提供了许多优化过的函数和操作,能够充分利用GPU的并行计算能力。3. **分批处理数据**:对于大规模的数据集,采用分批处理的方式可以减少内存占用并提高计算的吞吐量。将数据切分成适合GPU内存的小批量进行训练,这样能够防止内存溢出,并使得训练过程更加高效。4. **监控和调试**:使用工具监控GPU的利用率和内存使用情况,及时识别性能瓶颈。在CodeWithGPU提供的环境中,可以通过可视化工具观察资源的使用情况,帮助您进行代码优化。5. **学习多线程编程**:理解CUDA(Compute Unified Device Architecture)等并行编程模型,有助于在CodeWithGPU中更有效地实现算法。熟悉多线程和异步编程能够使您编写的代码更具性能,提升整体运行效果。通过以上技巧,您可以更加高效地使用CodeWithGPU,优化您的计算任务,提升工作效率。

同类工具

同类工具